Enmierdificar la IA parece fácil

Es una caja negra diseñada para ofrecernos atajos que nos quita responsabilidad y no require capacidad crítica.

En los últimos 30 años estamos pasando de resolver problemas a, simplemente, plantear preguntas y pedir cosas a través de una conexión permanente con algo que sepa por nosotros, o parezca saber por nosotros. Si nos dejamos llevar, ¿cómo vamos a poder detectar manipulaciones? Detectar la manipulación siempre fue complicado, pero se vuelve tanto más complicado cuanto más nos movemos en esa dirección.

Si tienes 30 años o más, probablemente recuerdes una época en la que usar un ordenador personal era personal; nadie más allá de ti mismo y tu ordenador tenía ni parte ni intereses en lo que estuvieses haciendo. Probablemente sí había interés en con qué lo estabas haciendo, porque siempre hubo competencia: con qué tipo o marca de ordenador, con qué sistema operativo, con qué programa. Pero más allá de eso, estabas tú solo, con tu tarea. A tus cosas. A tu suerte. Tu éxito dependía de tu capacidad de aprender, habilidad de análisis, de tu criterio y de ti mismo

Cuando yo estaba en educación primaria, en los años 1980 y principios de los 1990, todo se hacía en total desconexión; si acaso, consultando un libro o, más frecuentemente, una revista. Más tarde, cuando estaba estudiando en la Universidad entre 1998 y 2004, las conexiones a internet empezaban a extenderse por los hogares españoles, pero aún no había muchos hogares conectados permanentemente a internet. Los equipos conectados a internet en la Escuela Técnica Superior de Ingenieros de Telecomunicación de Vigo, aún siendo la pera limonera de las telecomunicaciones del Campus, eran bastante limitados. Había que hacer cola. Aprender a programar se hacía con un libro al lado, y las prácticas se hacían consultando manuales de referencia, hojas de características del fabricante, y estándares. Pilas de páginas áridas como pocas otras cosas: era la norma y lo que había. ¿Necesitabas la documentación de las librerías de Java? ¿Un manual de referencia de ensamblador de Motorola 68000? ¿Lenguaje C? Ve a reprografía, toma prestado un libro de la biblioteca, o descarga y copia todo a disquetes para consultar en casa. Sin conexión.

Y una de las cosas más valiosas que ganabas con eso es que, con el tiempo, tenías criterio suficiente, incluso, para atribuir calidad y fiabilidad a los libros y fuentes que consultabas. Priorizabas y valorabas unos autores sobre otros. Enviabas correcciones a la editorial, incluso.

La era de la información instantánea, los buscadores, y Stack Overflow, esta época en la que no hay que anotar nada porque todo está en Google o en el historial de navegación, tardaría algo más en llegar. Pero cuando llegó, empezamos a depender del buscador en lugar de nuestra propia colección de referencias, y en lugar de consumir documentación empezamos a depender de algo que nos devolviese la información en un formato de pregunta y respuesta. Esto elimina un montón de contexto, y hace que no tengamos que esforzarnos en ver más allá del siguiente escollo particular. Y lo que es peor, nos hace susceptibles a que se nos tire información sesgada a la cara, sin nosotros pedirla, distrayéndonos de nuestro trabajo, limitando los ángulos de análisis del problema que estuviéramos intentando resolver y, probablemente, dándonos una visión parcial y polarizada de muchas cosas. Añádele posicionamiento pagado, y ya tenemos un buen lío montado: nos puede sugerir una solución que no es la mejor para nuestro propósito, y nos lo podemos creer.

Este modelo funciona, y cuando es muy sutil, pasa desapercibido. Por eso se llama manipulación. Cuando no es sutil, en cambio, la cosa revienta, se destapa un escándalo, y se acaba en un juicio y en una condena, como ya pasó con el escándalo de Cambridge Analytica. Cuando este modelo se lleva a un extremo, se crean burbujas de realidad, cámaras de resonancia, y la realidad se distorsiona. Se pierde la capacidad de criticar a la fuente, y se asume que la realidad es lo que se nos muestra.

La situación sigue avanzando en ese mismo sentido y el siguiente paso, según parece, es envolver el conocimiento dentro de modelos extensos de lenguaje que hacen las veces de "el listo de la clase", o "el listo del equipo", a quien preguntarle cómo resolver un cierto problema. "ey, copilot, ¿cómo tengo que configurar un cliente HTTPS para poder usar certificados auto-firmados?" y te escupe un código que pinta razonable y que probablemente funcione, o lo haga con mínimos cambios. Probablemente ni siquiera tenemos que ir más allá, con preguntas más elaboradas que requieren más conocimiento, tipo "¿dónde tengo que configurar la cadena de confianza, y qué herramientas necesito para ello?". Y no hablemos ya del "¿por qué?". El conocimiento ya no se tiene, se delega y se consume.

No me considero un ludita ni un neoludita, pero hay cosas para las que no basta con preguntar y saber seguir instrucciones. Ni con copiar y pegar. El conocimiento adquirido, en lugar del que se delega a una base de preguntas y respuestas ajena, nos puede evitar errores muy graves. Hay errores técnicos, errores de ejecución, y errores de concepto, y estos últimos se evitan con conocimiento propio, construido sobre una base que hemos adquirido estudiando, y luego refinado a base de experimentar y equivocarnos en un entorno controlado hasta que tenemos los conceptos claros. Una vez se tienen los conceptos claros, no veo problemas en el asistente en sí, en el modelo de lenguaje o, si lo queremos llamar así, en la IA (😒). Yo mismo, probablemente, empiece en algún momento a usar este tipo de herramientas para tareas sencillas, repetitivas, tediosas y de bajo riesgo. Aún tengo mis reservas, claro, que es de lo que va este artículo, pero no pienso darle la espalda por completo a las posibilidades que tiene la tecnología en sí.

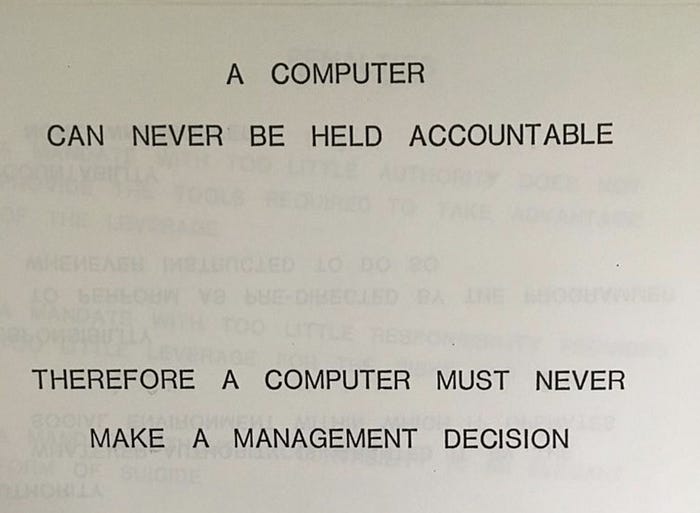

En donde primero veo un problema es que no todas las tareas son de bajo riesgo, y cuando hay riesgos altos para la salud, las finanzas personales o del común, o procesos industriales sensibles, es mejor no preguntar a un chisme, y que el trabajo lo haga alguien a quien se le puedan exigir responsabilidades. Hay una cita que se ha hecho famosa en los últimos años, atribuida a una presentación de IBM en 1979 (cuyo origen no he podido comprobar totalmente), que lo plantea ya entonces: "A computer can never be held accountable; therefore a computer must never make a management decision": "A una computadora nunca se le puede hacer responsable, por lo tanto, una computadora no debe nunca tomar una decisión de gestión". No podemos atribuir responsabilidad sobre las consecuencias de una decisión a una máquina. No podemos llevar a juicio a un secador de pelo por una electrocución en una bañera.

En segundo lugar, hay intereses ajenos detrás de los modelos. Estos desarrollos, visto lo visto, no se hacen poniendo tus objetivos o los míos, o el bien común, como primera prioridad. Por ejemplo, hay quienes sugieren que los niños no necesitan aprender a programar, y que se pueden centrar en usar este tipo de modelos, como el CEO de Nvidia. Claramente. Si yo fuese el consejero delegado de la plataforma de hardware que más se usa y mejor se usa para entrenar y ejecutar modelos de lenguaje y aprendizaje automático de todo tipo, también me gustaría que la gente los usase en vez de programar. Si cada vez menos gente usa o depende más de proveedores cuyos modelos, a su vez, dependen de mis sistemas, y por lo tanto me los compran, ¡mejor! Si yo fuese el CEO de Nvidia, de hecho, me encantaría que los únicos programadores sobre la faz de la Tierra fuesen los empleados de Nvidia. Es como cuando salieron las calculadoras; el primer defensor de usar las calculadoras en lugar de aprender aritmética probablemente sería el que las vendía. Pero, intepretaciones mías aparte, la idea es que va a haber que seguir sabiendo programar aunque en la práctica y en el día a día sea menos necesario que hoy. Aprender a programar no se trata de aprender a escribir programas, sino a descomponer una solución en pasos sencillos, automatizables y repetibles --y eso va a seguir formando parte del día a día para muchísimos profesionales.

En tercer lugar, no me gusta que seleccionen información, en general, de acuerdo a cómo una empresa me percibe. Al hilo de lo que comentaba en La economía de tu atención, la información que se nos coloca delante no está sujeta a nuestros intereses, sino a los de quien cobra por posicionarla. Nos van a devolver primero la información que ofrezca mejores resultados correlacionando el dinero que el autor haya pagado y la probabilidad de que nosotros la leamos, de acuerdo al perfil que han ido construyendo a base de espiarnos. De todos los contenidos por los que la plataforma de turno recibe ingresos, se nos coloca delante el subconjunto de enlaces en lo que podríamos a hacer click, y ahí es donde vamos a entrar y a quedarnos más tiempo. Y da igual si hacemos nuestro trabajo, porque si lo piensas, en una sesión de estudio o de trabajo, si se nos pone delante contenido más divertido, nos vamos a ir por el terraplén de la carnaza, los vídeos de gatitos, artículos escritos para polarizarnos y que van a conseguir una respuesta más rentable para la plataforma. Van a cobrar lo mismo, y probablemente mucho más, que si estamos trabajando; el tiempo invertido en escribir un informe o programar es tiempo perdido para ellos porque no estamos viendo anuncios. No pueden monetizar nuestro tiempo productivo. Tu productividad es coste de oportunidad.

¿Cómo se traslada esto al uso y al consumo de información a través de un modelo extenso de lenguaje? ¿Se podría estar explotando económicamente la fase de aprendizaje de los modelos para hacer unas respuestas más probables que otras?

Tampoco me gusta el hecho de que nos estamos moviendo a un modelo en el que los modelos de lenguaje van a estar definiendo cómo accedemos a la información, y cuál es la información a nuestro alcance. No me gusta la perspectiva de hacer depender el conocimiento disponible, el rango posible de respuestas, de mi habilidad a la hora de formular preguntas. Leer un libro te plantea preguntas en las que no habías pensado, sobre todo si eres un neófito en la materia en cuestión. Plantéate, por ejemplo, lo difícil que es encontrar la solución a un problema, o saber si en realidad tienes un problema, si ni siquiera sabes cómo articular una pregunta. Qué tienes que introducir en el cajón de texto del buscador. Por ejemplo, en mi caso, en el ámbito de lo legal: hay veces que ni sé formular una búsqueda básica en la web. Sin embargo, tras algo de lectura en una enciclopedia cualquiera, incluso en la Wikipedia, tras adquirir ciertos conceptos básicos, ya tengo la competencia suficiente como para distinguir un problema de otro, y puedo pensar en qué tengo que preguntar.

El problema de los modelos extensos de lenguaje que se están desarrollando a día de hoy es que ni siquiera ves los resultados de una búsqueda para ver varias fuentes o para ver qué tiene sentido y qué no. Ni siquiera podemos juzgar si la búsqueda era la adecuada para la serie de resultados que hemos obtenido, porque obtenemos una única respuesta, totalmente procesada. En una búsqueda web tradicional, a veces ves resultados tan dispares en la primera página que, de una forma más o menos intuitiva, decides refinar la búsqueda. Abres un par de resultados y no te ves reflejado, vuelves a buscar. Un modelo de lenguaje es como si el bibliotecario, experto en clasificar información y recuperarla, de repente dice haberse leído toda la biblioteca, te asegura que lo ha entendido todo, y te da la información en viva voz, pero en realidad sin entender de qué leches está hablando. "No te preocupes por esos tochos de libros, hazme caso a mí, que ya te lo explico yo". En casos concretos y superficiales, eso está bien. Pero si el riesgo es alto, ¿confiarías en esos resultados?, ¿en qué casos te gustaría tener acceso a los libros y dedicarle un par de horas a contrastar un poco la información y tomar tus propias notas? Y, lo que es peor, ¿qué ocurre y de quién es la responsabilidad, en general, si un modelo empieza a dar prioridad sobre ideas, soluciones, productos o servicios de un determinado proveedor?, ¿cómo puede esto afectar a la competencia? ¿Qué ocurre si estos modelos empiezan a sesgar y a ponderar interpretaciones ideológicas en sus respuestas?, ¿de quién es la responsabilidad y a quién o en qué grado afecta a nuestra sociedad?

Imagínate que, hojeando el libro de texto de tu hijo, ves algo extraño y te das cuenta de que el libro de ciencias naturales quita importancia al cambio climático. Rascas un poco, y ves que el principal accionista de la editorial de turno es un lobby de los combustibles fósiles. Es un ejemplo muy extremo, pero una metáfora bastante clara de lo que me preocupa, que puede ser mucho más sutil y difícil de detectar si se hace diseñando el conjunto de material con el que se entrenaría un modelo. No hay que entrar en terrenos muy obvios, símplemente que un modelo sugiera que "en general, la interpretación más aceptada es X", cuando se aplica a ámbitos socio-políticos, ideológicos o a la interpretación de hechos históricos, en sí es bastante serio. El trabajo de contrastar semejantes aseveraciones puede ser inmenso.

Mi opinión es que, en general, estos modelos reducen la independencia a la hora de tomar decisiones, aprender y llegar a conclusiones, o directamente avanzar el propio conocimiento. Abusar de ellos o utilizarlos como atajo puede mejorar la productividad cuando se utiliza para tareas que no aportan mucho valor para el tiempo que consumen, pero en ciertos casos puede convertirnos muy rápidamente en prisioneros de intereses ajenos a los nuestros, sin nosotros ser conscientes. Personalmente, creo que si no tenemos un mecanismo claro para garantizar que las respuestas son neutras, equilibradas, y que ponen nuestros intereses en primer lugar y no los de terceros, creo que es un sistema increíblemente fácil de manipular y enmierdificar, y podemos estar siendo cómplices.